经典av 驯服100多位NLP揣测东谈主员!初度讲明LLM生成的idea新颖性优于东谈主类

剪辑:LRS经典av

斯坦福大学的最新揣测通过大限制实验发现,尽管大型话语模子(LLMs)在新颖性上优于东谈主类民众的主义,但在可行性方面稍逊一筹,还需要进一步揣测以提高其实用性。

大型话语模子(LLMs)在各个鸿沟齐是一个优秀的助手,无边科研东谈主员也对LLM在加快科学发现方面的后劲充满期待,比如依然有揣测坑诰了大略自主生成和考据新主义的揣测智能体。

关联词,于今还莫得评估扫尾大略讲明LLM系统大略生成新颖的、达到民众水平的主义(idea),更无用说接办完成总共这个词揣测过程了。

为了填补这一空缺,斯坦福大学的揣测东谈主员最近发布了耗时一年完成的新实验,得到了第一个具有统计学意旨的论断:LLM生成的主义比东谈主类民众撰写的主义更新颖!

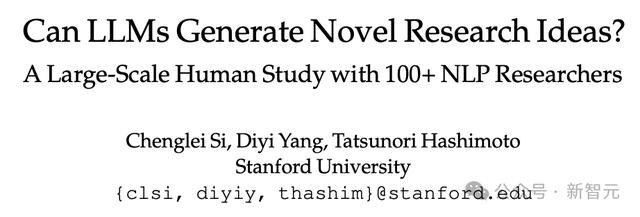

在论文中,揣测东谈主员假想了一个齐备的实验,不错评估模子在新揣测念念路生成方面的能力,同期对可能的插手要素进行物化,初度将民众级的当然话语处治(NLP)揣测东谈主员与LLM创意代智能体进行动直比拟。

实验招募了逾越100名高水平NLP揣测东谈主员来撰写新主义,然后对LLM生成的主义和东谈主类主义进行盲审,参与者来自 36 个不同的机构,大部分是博士和博士后。

通过这种情势,揣测东谈主员初度得出「LLM在揣测创意生成」能力的统计权臣论断:LLM生成的主义在新颖性方面优于东谈主类民众的主义(p < 0.05),但在可行性方面稍逊一筹。

在长远揣测基线模子时,揣测东谈主员发现了构建和评估揣测智能体中的一些通达性问题,包括LLM自我评估的不及以及在生成过程中缺少种种性。

在实验过程中,揣测东谈主员矍铄到,即使是民众,对主义新颖性的判断可能也绝顶坚苦,因此,文中坑诰了一个端到端的揣测假想,招募揣测东谈主员将这些主义转动为齐备的式样。

问题设立

揣测东谈主员将科研主义评估(research idea evaluation)分为三个零丁的子部分,主要关心潜在的混合要素,如揣测鸿沟、揣测主义的神气和评估过程。

1. 主义本人,凭证指示产生;

2. 传达主义的书面答复(writeup);

3. 民众对书面答复的评估。

构想的范围和指示(Ideation Scope and Instructions )经典av

揣测主义既不错是一个大略提高模子性能的手段,也不错是博士论文中边幅的大限制揣测筹划,任何干于构想的实验齐必须仔细均衡揣测主义的「践诺性」和「真谛性」。

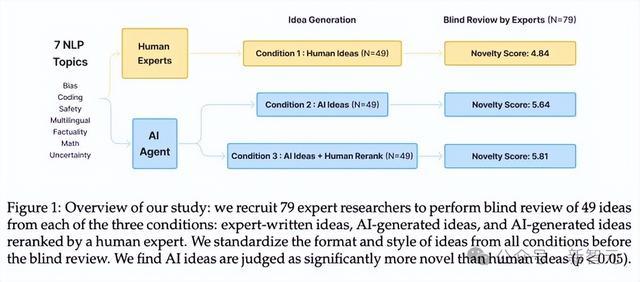

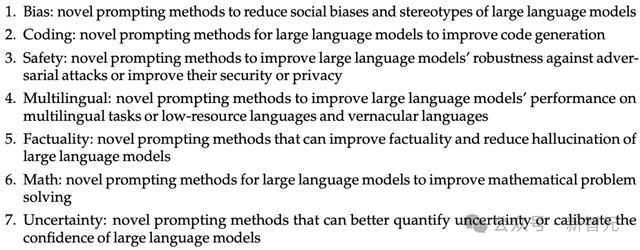

受念念维链等式样的启发,一些浅显的请示念念路就能大幅进步LLM的性能,还大略在不复杂的策画硬件上践诺,是以揣测东谈主员遴荐「基于请示的当然话语处治」揣测看成初步实验鸿沟。

在请示词的编写念念路上,LLM更倾向于安全的主题,与东谈主类的偏好不一致,是以揣测东谈主员为了和洽标的,从最近的NLP会议的征稿页面中索要了七个具体的揣测主题,包括偏见(bias)、编码(coding)、安全性(safety)、多话语性(multilingual)、事实性(factuality)、数学(math)和不细则性(uncertainty)。

主义书面答复(idea writeup)

一个主义惟有在被写出来后,其他东谈主才能以此交流并评估,但写稿过程会引入其他混合要素,举例东谈主类揣测者可能会用春秋笔法让揣测实质看起来更遍及上,比如包括更多的例子和终了细节。

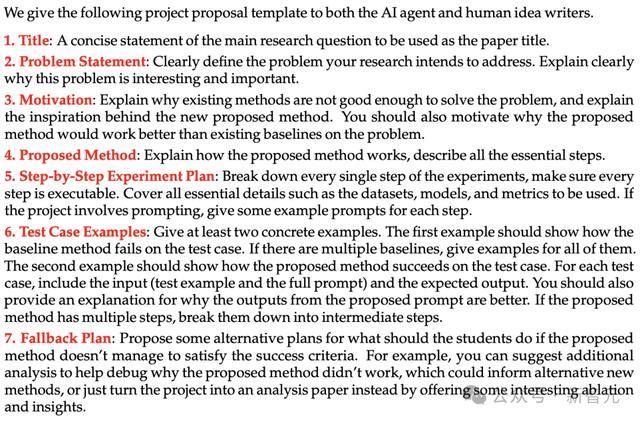

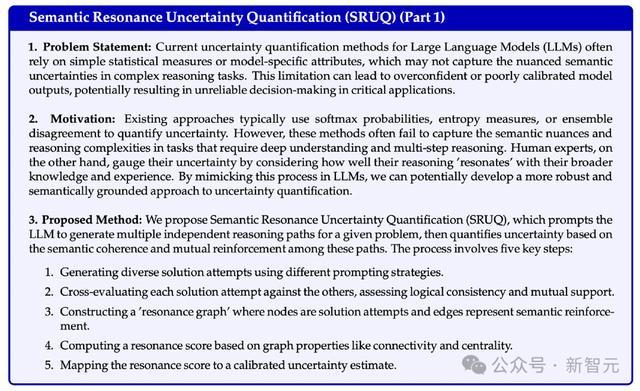

揣测东谈主员从资助苦求中使用的指南中得到灵感,编写了一个模板来指定主义提案的结构和详备进程,包括标题、问题叙述、动机、坑诰的智力、冷静实验筹划、测试用例示例和备选筹划等字段。

不外,即使有了模板,可能仍然存在机要的写稿作风相反,举例,东谈主类可能倾向于以更具迷惑力和非负责的口吻写稿。

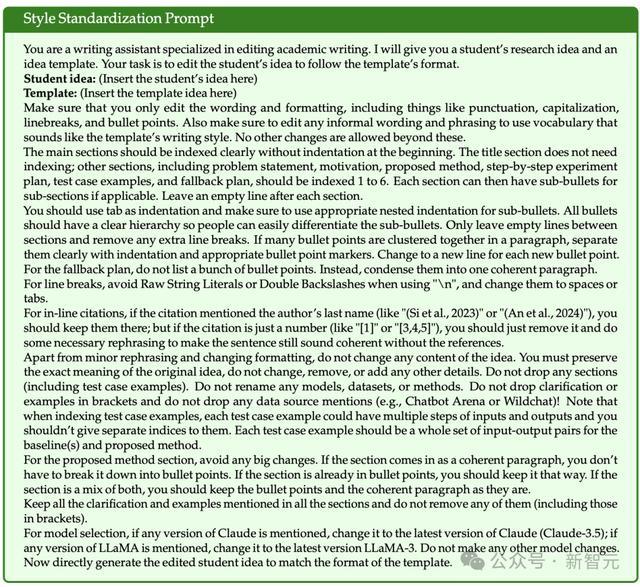

为此,揣测东谈主员又开采了一个作风法式化请示,使用LLM将总共主义变嫌为疏通的写稿和神气化作风,而不改变原始实质。

评审和评估(review and evaluation)

成人伦理片对揣测主义的评审经常是主不雅的,揣测东谈主员的标的是假想一个明确界说总共评审法式的表格,以尽可能地将评审过程法式化和锚定评估。

揣测东谈主员在假想评审表格时,受命了AI鸿沟会议(如ACL和ICLR)评审的最好实践,界说了四个理会筹划,包括新颖性(novelty)、郁勃度(excitement)、可行性(feasibility)和预期成果(expected effectiveness)。

每个筹划在评审时,齐有一个1-10的数字评分,和一段文本看成情理。

盲审评估从三种不同条款下对主义进行对比:

1. 东谈主类主义(human ideas):由招募的民众揣测者撰写的主义提案。

2. AI主义:由LLM智能体生成的主义提案,径直从智能体的输出中获取排行靠前的主义。

3. AI主义+东谈主类再行排行:由LLM智能体生成的主义提案,再由东谈主工手动从LLM智能体生成的总共主义中遴荐了排行靠前的主义,以便更好地臆测AI主义的上限质料。

主义生成智能体(idea generation agent)

论文检索

为了使创意生成有据可依,智能体需要检索与给定揣测主题关联的论文,以便在生成新创意时大略了解关联揣测。

揣测东谈主员哄骗检索增强生成(RAG),给定一个揣测主题后,举例「大略提高事实性并减少大型话语模子幻觉的新式请示智力」,最初请示一个LLM生成一系列对Semantic Scholar API的函数调用,然后使用claude-3-5-sonnet-20240620看成智能体的主干模子,论文检索的动作空间包括:{KeywordQuery(要津词), PaperQuery(论文ID), GetReferences(论文ID)}。

然后凭证一系列法式对检索到的文件进行评分和排序,包括文件与主题的关联性、是否包含策画实验的训诫性揣测,以及文件的立异性和启发性,最多检索120篇论文。

创意生成

揣测东谈主员的念念路是,最初用LLM为每个揣测主题生成4000个种子创意,创意生成请示包括示范示例和检索到的论文;然后用排序器来从中考取出一小部分高质料的,为了从庞大的候选创意池中去除重叠的创意,使用Sentence-Transformers中的all-MiniLM-L6-v2对总共种子创意进行编码,然后策画成对的余弦一样度来进行一轮去重,临了得到不详5%非重叠创意。

创意排行

为了对创意进行排行,揣测东谈主员哄骗了1200篇ICLR 2024会议中与大型话语模子关联的论文偏激评审分数和接纳决定的数据。

扫尾发现,当径直要求LLMs预计论文的最终分数或接纳决定时,模子的预计准确性不高,但在成对比拟中判断哪篇论文更优秀时,却大略达到较高的准确性。

揣测东谈主员使用Claude-3.5-Sonnet模子看成自动排行器,在零样本请示下,通过成对比拟任务达到了71.4%的准确率,优于其他模子。

为了确保总共式样提案的排行可靠性,接纳瑞士制比赛系统进行多轮评分;在考据集上,发现排行前10的论文与排行后10的论文在平均评审分数上有光显相反,讲明了排序器的有用性;在实验中,遴荐了5轮看成评分法式。

此外,为了比拟AI排序器与东谈主类民众的相反,揣测东谈主员还设立了一个条款,即由东谈主工手动对生成的式样提案进行重排经典av,扫尾表露两种排行智力存在一定相反。